네이버 부동산 매물 데이터를 자동으로 수집해봤습니다

매일 네이버 부동산 들어가서 매물 확인하기,

꽤 번거로운 일입니다.

특히 관심 있는 단지가 몇 군데라면 더 그렇죠.

그래서 직접 만들었습니다.

네이버 부동산 매물 데이터를 자동으로 수집하는 작은 프로그램.

크롤링? 어렵지 않습니다

처음엔 ‘이거 내가 할 수 있을까’ 싶었는데

막상 해보니 흐름만 익히면 충분히 가능하더라고요.

핵심은 네이버 부동산에서 데이터를 불러올 때 사용하는 API 구조를 파악하는 것이었습니다.

- 페이지를 열고

- 개발자 도구에서 ‘네트워크 > XHR’ 필터 켜고

- 스크롤을 내리면서 나오는 요청을 확인

여기서 필요한 요청 URL과 함께 payload, 즉 전달값 구조까지 확인해 두면

그대로 파이썬으로 가져올 수 있습니다.

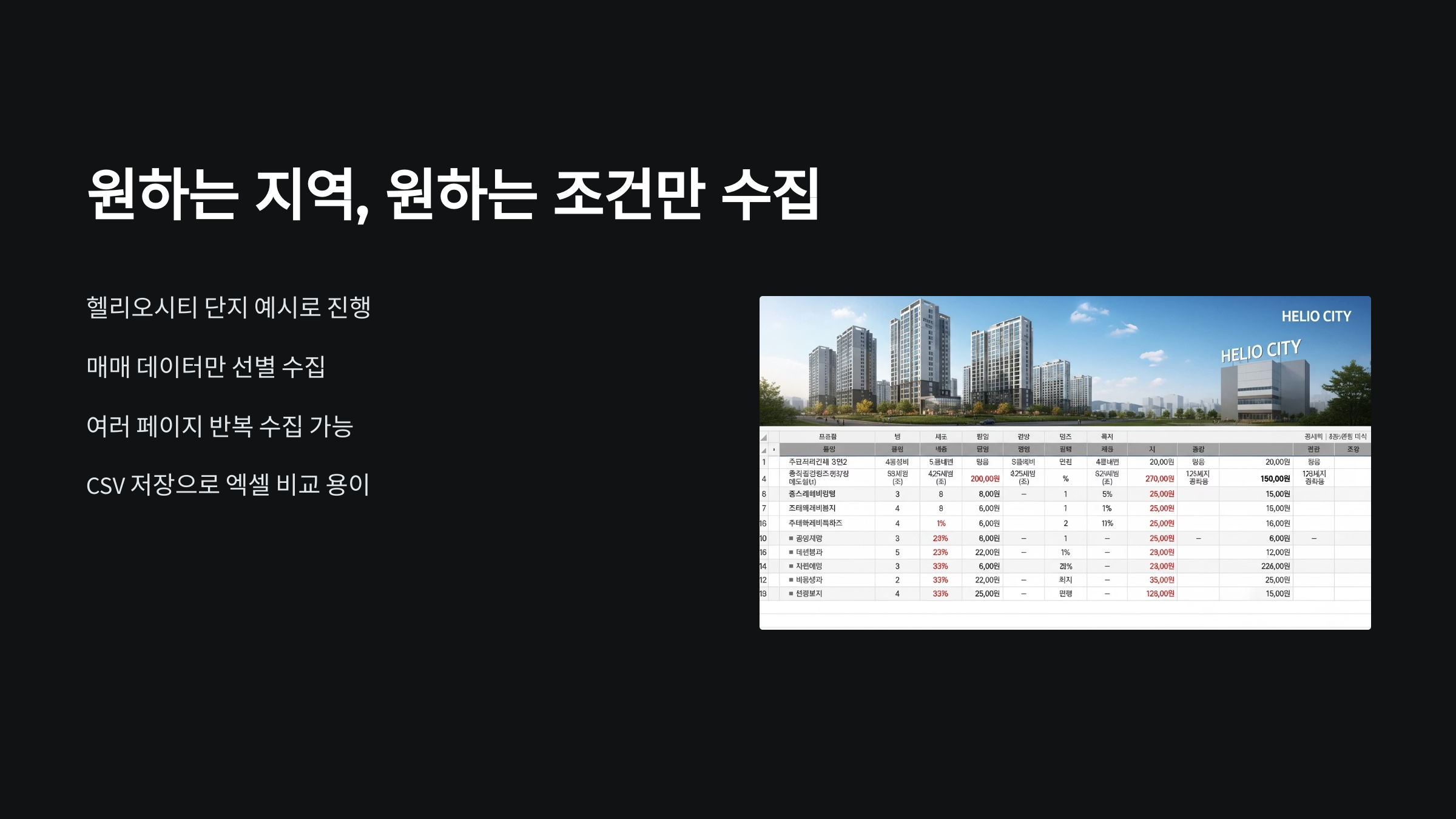

원하는 지역, 원하는 조건만 수집

저는 헬리오시티 단지를 예시로 했습니다.

매매 데이터만 골라서, 여러 페이지의 정보를 반복적으로 불러오게 설정했죠.

페이지 수만 바꿔주면 1페이지부터 10페이지까지

혹은 그 이상도 자유롭게 수집할 수 있고요.

CSV로 저장하게 해두면 나중에 엑셀에서 비교하기도 편합니다.

1년 전 데이터랑 지금 데이터 비교해보는 것도 의미 있죠.

슬랙 연동까지 해두면 더 편합니다

제가 따로 시간 내지 않아도

매일 아침마다 슬랙으로 데이터가 자동 도착합니다.

이전 대비 가격이 어떻게 변했는지,

급매로 보이는 건 어떤 건지 확인하는 데 도움이 되더라고요.

Streamlit으로 간단한 웹페이지도 가능

만든 데이터를 보기 쉽게 만들고 싶어서

Streamlit이라는 파이썬 라이브러리를 써봤습니다.

몇 줄만 추가하면 크롤링된 데이터를

웹 브라우저에서 손쉽게 확인할 수 있는 뷰어가 만들어져요.

‘다음 페이지’ 버튼만 누르면 호가가 바뀌고,

실시간으로 가격 흐름을 확인할 수 있습니다.

부동산 감각, 데이터로 키울 수 있습니다

매일매일 들어가서 보는 것도 중요하지만

데이터를 모으고 흐름을 분석해보는 건 전혀 다른 감각입니다.

요즘 시장 분위기가 어떤지,

예전에 봤던 급매가 진짜였는지,

감이 더 명확해집니다.

크몽이나 외주로 맡기지 않아도

직접 해보면 충분히 만들 수 있는 수준이었습니다.

정리하며

- 원하는 단지, 원하는 조건만 골라서 수집 가능

- 매일 자동으로 CSV 저장 또는 슬랙으로 전달 가능

- 파이썬 + Streamlit 조합으로 웹 형태 시각화 가능

- 투자를 위한 데이터 감각도 함께 키워짐

시간은 10~15분이면 충분했습니다.

이 프로세스 하나 익혀두면

다른 사이트 크롤링도 비슷한 구조로 확장 가능하니까요.

본 글은 외부 콘텐츠를 참고해 개인적인 해석과 관점으로 재정리한 글입니다.

직접 테스트하고 응용해보며 작성했습니다.

'경제' 카테고리의 다른 글

| 서울 집값 왜 또 오르나? 실거주 수요 폭주와 대책 전망까지 정리 (1) | 2025.06.20 |

|---|---|

| 가계대출 규제 시작되면 어떻게 바뀔까? 6월 말 부동산 대책 예고된 상황 정리 (1) | 2025.06.19 |

| 서울 집값 다시 급등? 거래량·정책 흐름 총정리 (3) | 2025.06.19 |

| 부모님 집 마련, 아파트가 빌라보다 나은 진짜 이유 (1) | 2025.06.19 |

| 진보 vs 보수, 어느 쪽이 집값 올릴까? 실제 데이터로 분석해봤다 (2) | 2025.06.19 |